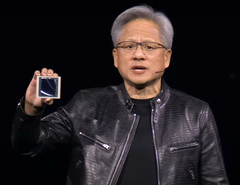

英伟达首席执行官黄仁勋在 2024 年 3 月 18 日于加利福尼亚州圣何塞举行的GTC 2024 主题演讲中透露了公司最新的人工智能产品和服务。2024 年 3 月 18 日在加利福尼亚州圣何塞举行的 GTC 2024 大会上发表主题演讲时透露了公司最新的人工智能产品和服务。针对企业客户,Nvidia 的新产品有望大大加快人工智能的学习,并应用于机器人、天气预报、药物发现和仓库自动化等多个领域。Nvidia Blackwell GPU、NIMs、NEMO 和人工智能代工厂等产品引人注目。

与使用人工智能模型相比,人工智能训练过程的计算机密集度要高得多,因为必须处理数百万个输入文档。对于像微软这样的公司来说,这在目前最快的超级计算机上也需要数周甚至数月的时间。英伟达公司曾于 2022 年发布了Hopper GPU 平台,用于处理此类大型计算。来处理如此大的计算负荷。

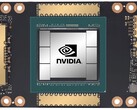

在2024年的GTC大会上,黄仁勋发布了Blackwell,作为Hopper的后续产品,Blackwell可作为现有Hopper安装的插件板替代品。Blackwell GPU 由双 1040 亿晶体管 GPU 芯片组成,采用 TSMC 4NP 工艺。(可能是 N4P,演示文稿中的错别字),可达到 20 FP4 petaflops,配备 192GB HBM3e 内存,传输速度可达 8TB/s。相比之下,台式机 4090 GPU拥有单个 763 亿晶体管 GPU,采用 5NM 工艺,性能高达 1.32 Tensor FP8 petaflops,配备 24GB GDDR6X 内存。如果将 4090 FP8 的数字翻倍调整为 4 位,那么 Blackwell 大约为 20 petaflops,而 4090 为 3 petaflops。

当 72 个 Blackwell GPU 被架设在一个DGX GB200 NVL72机柜,再加上液体冷却、改进的NVLink CPU和其他互连改进后,与 Hopper 机柜相比,FP8 AI 训练性能提高了 22 倍,FP4 AI 推断性能提高了 45 倍。Blackwell 人工智能训练的功耗也比 Hopper 降低了约 4 倍。

NIMS 预封装人工智能模型

为了利用这一性能飞跃,Nvidia 推出了名为NIMS(Nvidia Inference Microservice)的预包装人工智能模型。利用Kubernetes在本地或云端的 Nvidia CUDA GPU 上运行。通过简化的 HUMAN API 可以访问独立的 NIMS。这样做的目的是为了在未来创造一种人工智能服务,即要求人工智能创建一个具有特定功能的应用程序,然后人工智能将各种 NIMS 混合并匹配在一起,而无需进行底层编程。最后,为了帮助培训 NIMS,Nvidia 推出了NeMO 微服务对企业文件的培训过程进行定制、评估和防护。

Nvidia BioNeMO 和生物 NIMS

黄晓庆宣布,Nvidia 将开发在生物和医学数据上进行训练的 NIMS,为研究人员提供更便捷的人工智能访问,从而改善医学的方方面面,例如更快地找到候选药物。

雷神ASIL-D和比亚迪自动驾驶电动汽车

值得注意的是,黄仁勋表示,比亚迪将成为全球首家采用全新Thor ASIL-D 计算机的电动汽车制造商。利用人工智能 SoC 处理视觉和驾驶输入,为自动驾驶提供高安全性。加上最近发布的 SuperDrive by Plus,这表明比亚迪将成为全球首家采用 Thor ASIL-D 计算机的电动汽车制造商。这表明比亚迪将成为首批发布Level 4自动驾驶电动汽车。

Nvidia Project Groot 人形机器人

黄仁勋进一步展示了他们在机器人技术方面的进步,展示了他们的机器人的能力,这些机器人首先在Omniverse中作为数字孪生体进行训练,然后让其在 Omniverse中进行训练,然后让其在 Omniverse中进行训练。作为数字孪生体进行训练,然后让它们以现实生活中的机器人身体完成任务。他们展示了烘焙、用手指旋转木棒、产品分类和组装以及绕过障碍物的能力。为了达到这样的机器人技术水平,Nvidia Project Groot人工智能是通过首先对文本、视频和演示输入进行训练,然后通过实际观察任务的完成情况来进一步完善的。与车辆中使用的 Thor 计算机和Nvidia Tokkio AI语言模型,演示机器人能够观察人类所做的动作,然后复制这些动作来制作饮料、击鼓并响应口语请求。

Nvidia Omniverse Cloud 新增Apple Vision Pro 支持

值得注意的是,黄晓庆表示,Nvidia Omniverse Cloud现在可以向 Apple Vision Pro头戴式耳机。 元探索和 HTC Vive Pro由于 Macintosh 没有兼容的 Nvidia GPU,因此显然是为使用 Nvidia 云 GPU 的开发者准备的。

想要加入人工智能革命的读者将需要一块功能强大的 Nvidia 显卡(比如亚马逊的这款)来开发人工智能技能和应用程序。

英伟达™(NVIDIA®)发布由 Blackwell 驱动的 DGX SuperPOD,实现万亿次参数规模的生成式人工智能超级计算

利用最先进的英伟达网络、英伟达全栈式人工智能软件和存储,可扩展至数万颗Grace Blackwell超级芯片 利用英伟达NVLink,可将多达576颗Blackwell GPU连接为一体 英伟达系统专家加快了即时人工智能基础设施的部署速度

2024 年 3 月 18 日

GTC-NVIDIA®(英伟达™)今日宣布推出下一代人工智能超级计算机--由英伟达GB200 Grace Blackwell超级芯片驱动的NVIDIA DGX SuperPOD™,用于处理万亿参数模型,并为超大规模的生成式人工智能训练和推理工作负载提供稳定的正常运行时间。

全新的DGX SuperPOD采用全新的高效液冷机架式架构,由英伟达DGX™ GB200系统构建而成,可提供11.5 exaflops的FP4精度人工智能超级计算能力和240 TB的快速内存,并可通过增加机架扩展至更多。

每个DGX GB200系统拥有36个英伟达GB200超级芯片,其中包括36个英伟达Grace CPU和72个英伟达Blackwell GPU,通过第五代英伟达NVLink®连接成一台超级计算机。与英伟达™(NVIDIA®)H100 Tensor Core GPU相比,GB200超级芯片在大型语言模型推理工作负载方面的性能最多可提升30倍。

"英伟达™(NVIDIA®)公司创始人兼首席执行官黄仁勋表示:"英伟达DGX人工智能超级计算机是人工智能产业革命的工厂。"全新的DGX SuperPOD结合了英伟达加速计算、网络和软件方面的最新进展,使每家公司、每个行业和每个国家都能完善和生成自己的人工智能。"

由格雷斯-布莱克韦尔(Grace Blackwell)驱动的DGX SuperPOD拥有8个或更多的DGX GB200系统,可以扩展到通过英伟达量子InfiniBand连接的数万个GB200超级芯片。客户可以部署一种配置,将576个Blackwell GPU连接到8个通过NVLink连接的DGX GB200系统中,以获得支持下一代人工智能模型的海量共享内存空间。

面向生成式人工智能时代的新型机架规模DGX SuperPOD架构

配备DGX GB200系统的新型DGX SuperPOD具有统一的计算结构。除了第五代英伟达™(NVIDIA®)NVLink之外,该架构还包括英伟达™(NVIDIA®)BlueField®-3 DPU,并将支持今天单独发布的英伟达™(NVIDIA®)Quantum-X800 InfiniBand网络。该架构可为平台中的每个 GPU 提供高达每秒 1,800 千兆字节的带宽。

此外,第四代英伟达™(NVIDIA ®)可扩展分级聚合和精简协议 (SHARP)™技术可提供14.4 teraflops的网内计算能力,与上一代产品相比,下一代DGX SuperPOD架构的计算能力提高了4倍。

交钥匙架构搭配先进软件,实现前所未有的正常运行时间

全新的DGX SuperPOD是一个完整的、数据中心规模的人工智能超级计算机,它与英伟达认证合作伙伴提供的高性能存储集成在一起,能够满足生成式人工智能工作负载的需求。每台超级计算机都在工厂内完成构建、布线和测试,从而大大加快了在客户数据中心的部署速度。

格雷斯-布莱克韦尔(Grace Blackwell)驱动的DGX SuperPOD具有智能预测管理功能,可持续监控硬件和软件中的数千个数据点,预测并拦截宕机和效率低下的根源,从而节省时间、能源和计算成本。

即使没有系统管理员在场,该软件也能识别问题领域并制定维护计划,灵活调整计算资源,自动保存和恢复作业以防止停机。

如果软件检测到需要更换组件,集群将激活备用容量,以确保工作及时完成。任何所需的硬件更换都可以安排,以避免意外停机。

英伟达DGX B200系统为各行业推进人工智能超级计算

英伟达公司还发布了英伟达DGX B200系统,这是一个用于人工智能模型训练、微调和推理的统一人工智能超级计算平台。

DGX B200是风冷式传统机架式DGX设计的第六代产品,被全球各行业广泛使用。全新的Blackwell架构DGX B200系统包括八个英伟达™(NVIDIA®)Blackwell GPU和两个第五代英特尔®至强®处理器。客户还可以使用DGX B200系统构建DGX SuperPOD,以创建人工智能卓越中心,为运行多种不同工作的大型开发人员团队的工作提供动力。

DGX B200系统包括全新Blackwell架构中的FP4精度功能,可提供高达144 petaflops的人工智能性能、1.4TB的超大GPU内存和64TB/s的内存带宽。这使得万亿参数模型的实时推理速度比上一代产品提高了 15 倍。

DGX B200系统包括先进的网络连接,配备8个NVIDIA ConnectX™-7网卡和2个BlueField-3 DPU。每个连接可提供高达每秒400千兆比特的带宽--通过英伟达Quantum-2 InfiniBand和英伟达Spectrum™-X以太网网络平台提供快速的人工智能性能。

提供软件和专家支持以扩展生产型人工智能

所有英伟达 DGX 平台都包含用于企业级开发和部署的英伟达人工智能企业级软件。DGX客户可以利用软件平台中包含的预训练英伟达基础模型、框架、工具包和新的英伟达NIM微服务加快工作进度。

英伟达™(NVIDIA®)DGX 专家和经过认证可支持 DGX 平台的精选英伟达™(NVIDIA®)合作伙伴会在部署的每一个步骤中为客户提供帮助,使他们能够快速将人工智能投入生产。系统投入运行后,DGX 专家将继续支持客户优化其人工智能管道和基础架构。

可用性

配备DGX GB200和DGX B200系统的英伟达DGX SuperPOD预计将于今年晚些时候从英伟达的全球合作伙伴处发售。

欲了解更多信息,请观看GTC主题演讲重播,或参观3月21日在圣何塞会议中心举行的GTC英伟达展台。

» Notebookcheck多媒体笔记本电脑Top 10排名

» Notebookcheck游戏笔记本电脑Top 10排名

» Notebookcheck低价办公/商务笔记本电脑Top 10排名

» Notebookcheck高端办公/商务笔记本电脑Top 10排名

» Notebookcheck工作站笔记本电脑Top 10排名

» Notebookcheck亚笔记本电脑Top 10排名

» Notebookcheck超级本产品Top 10排名

» Notebookcheck变形本产品Top 10排名

» Notebookcheck平板电脑Top 10排名

» Notebookcheck智能手机Top 10排名

» Notebookcheck评测过最出色的笔记本电脑屏幕

» Notebookcheck售价500欧元以下笔记本电脑Top 10排名

» Notebookcheck售价300欧元以下笔记本电脑Top 10排名