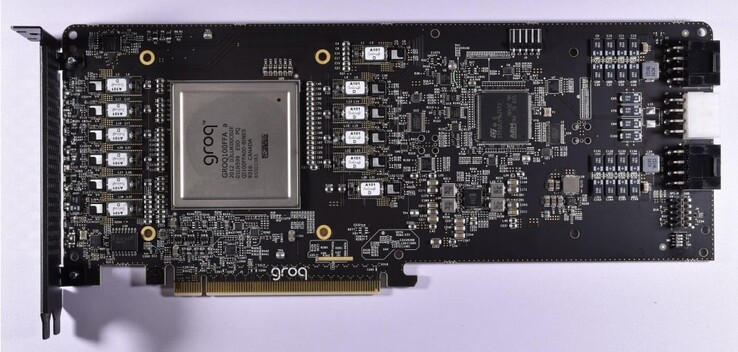

虽然 Nvidia 目前 利润但随着越来越多的公司加入提供可行的替代人工智能处理器的行列,市场可能会变得更加分散。我们已经看到多家公司在这方面做出了努力,其中包括 AMD, d-Matrix, OpenAI和 三星.看起来,曾经帮助设计谷歌张量处理单元(TPU)的许多工程师现在都参与了独立的人工智能项目,这些项目有望超越英伟达(Nvidia)的解决方案。例如,三星最近宣布,其在硅谷新成立的 AGI 计算实验室由前谷歌 TPU 开发人员 Woo Dong-hyuk 博士领导。另一位帮助开发谷歌 TPU 的关键工程师是乔纳森-罗斯(Jonathan Ross),他现在是一家名为 Groq 的新公司的首席执行官。凭借在谷歌积累的经验,罗斯为人工智能加速器市场带来了创新,推出了世界上第一个语言处理单元(LPU)。

Groq 的 LPU 专为处理大型语言模型(LLM)而设计。LLMs),与通用 GPU 或 NPUs.Groq 最初开发的是张量流处理器 (TSP),后来改名为语言处理单元,以反映其在基于推理的生成式人工智能任务方面能力的提升。由于只专注于 LLM,LPU 比 GPGPU 更加精简,可以简化调度硬件,降低延迟,提高持续吞吐量和效率。

因此,LPU 可以减少每个字的计算时间,更快地生成文本序列。另一项关键改进是,LPU 无需使用昂贵的内存(HBM)。HBM),因为每个芯片仅使用 230 MB SRAM,带宽为 80 TB/s,这使其速度大大快于传统的 GPGPU 解决方案。Groq 的架构还支持可扩展性,因为多个 LPU 可以相互连接,为更复杂的 LLM 提供更强的处理能力。

为了证明 LPU 推理引擎的速度比 GPU 快得多,Groq 提供了一段视频,比较了自己的聊天机器人在 Llama 2 / Mixtral LLM 与 OpenAI 的 聊天-GPT.Groq 声称,LLM 只需几分之一秒即可生成文本,其余 3⁄4 的时间用于搜索相关信息。

» Notebookcheck多媒体笔记本电脑Top 10排名

» Notebookcheck游戏笔记本电脑Top 10排名

» Notebookcheck低价办公/商务笔记本电脑Top 10排名

» Notebookcheck高端办公/商务笔记本电脑Top 10排名

» Notebookcheck工作站笔记本电脑Top 10排名

» Notebookcheck亚笔记本电脑Top 10排名

» Notebookcheck超级本产品Top 10排名

» Notebookcheck变形本产品Top 10排名

» Notebookcheck平板电脑Top 10排名

» Notebookcheck智能手机Top 10排名

» Notebookcheck评测过最出色的笔记本电脑屏幕

» Notebookcheck售价500欧元以下笔记本电脑Top 10排名

» Notebookcheck售价300欧元以下笔记本电脑Top 10排名